Pas de technologie déshumanisante

Laura Nolan est une programmeuse informatique qui a démissionné de Google à cause du projet Maven. Elle est maintenant membre du Comité international pour le contrôle des armements robotiques (ICRAC), membre fondateur de la Campagne pour arrêter les robots tueurs. #ÉquipeHumain.

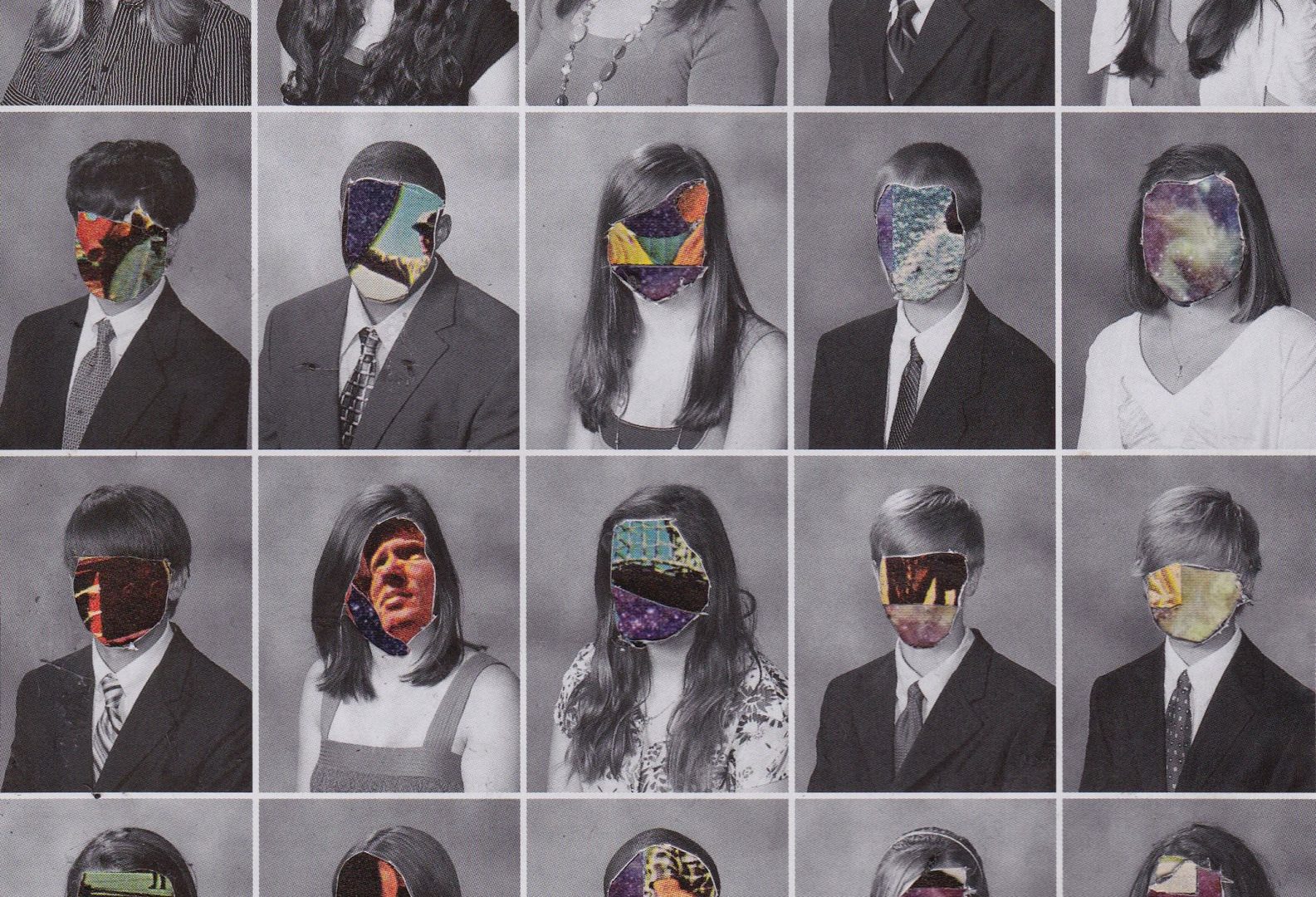

Photo par Photographie de John Sloan (CC BY-NC-SA)

La déshumanisation est le fait de ne pas reconnaître l'humanité des autres. C'est un déni de la dignité humaine — la valeur intrinsèque des personnes humaines — qui est l'une des pierres angulaires des droits de l'homme et de la pensée éthique moderne. Inversement, la déshumanisation peut être le premier pas vers la guerre, le génocide et d'autres atrocités.

Comment, en ee 21e siècle, construisons-nous et exploitons-nous des systèmes de protection sociale informatisés qui faire mourir de faim les allocataires or refuser les droits de base à ceux qui sont moins en mesure de naviguer dans un processus d'application complexe via un logiciel ?

Nous pouvons ne pas être traités comme des humains à part entière par les organisations avec lesquelles nous interagissons lorsque nous sommes réduits à un enregistrement dans un magasin de données. Les systèmes informatiques gèrent désormais la plupart des processus bureaucratiques, tels que les systèmes de protection sociale, et ils éloignent le personnel des effets du système. Comme l'écrit le célèbre sociologue et philosophe Zygmunt Bauman, « la distance pratique et mentale par rapport au produit final signifie […] que la plupart des fonctionnaires de la hiérarchie bureaucratique peuvent donner des ordres sans pleinement connaître leurs effets. Dans de nombreux cas, ils auraient du mal à visualiser ces effets.

Les ingénieurs logiciels qui construisent les systèmes de prise de décision sont généralement encore plus éloignés de l'effet des systèmes que nous construisons que les cadres supérieurs. Intentionnellement ou non, nous construisons souvent des systèmes rigides qui conduisent à de pires résultats pour de nombreuses personnes que les bureaucraties plus anciennes composées d'êtres humains ayant le pouvoir de prendre des décisions et de s'adapter aux exceptions.

Les systèmes de protection sociale ne sont qu'un exemple de ce genre de phénomène. Ibrahim Diallo était marqué à plusieurs reprises comme n'étant plus employé par les systèmes RH de son employeur. Il a effectivement été licencié par les ordinateurs.

La pandémie de COVID-19 a vu une augmentation du nombre d'interactions via des logiciels dans la plupart de nos vies. Les employés ont dénoncé les effets déshumanisants de surveillance automatisée par les employeurs. Étudiants passant des examens ont parlé de l'impact des logiciels de surveillance qui attire l'attention sur leurs handicaps, ne fonctionne pas avec la couleur de leur peau et est envahissante.

Être scruté, évalué et avoir des décisions prises à notre sujet par un logiciel semble souvent injuste et déshumanisant. Nous savons que les individus peuvent être soumis à des résultats injustes en raison de la prise de décision automatisée ou du profilage - c'est la raison de l'existence de Article 22 du Règlement général sur la protection des données de l'Union européenne :

La personne concernée a le droit de ne pas faire l'objet d'une décision fondée uniquement sur un traitement automatisé, y compris le profilage, produisant des effets juridiques la concernant ou l'affectant de manière significative de manière similaire.

Les citoyens des riches nations occidentales bénéficient souvent de certaines protections juridiques contre les manifestations les plus dommageables de la déshumanisation numérique. C'est moins vrai pour les autres. L'histoire de l'outil d'évaluation de la classification des risques de l'Immigration and Customs Enforcement (ICE) des États-Unis est une mise en garde. En 2017, ce l'outil a été modifié de toujours recommander la détention de tout immigré sans papiers, en rupture avec des années de pratique. Les agents pouvaient outrepasser la recommandation de l'outil, mais peu l'ont fait et les détentions ont monté en flèche.

Photo par év.

Bauman souligne que « l'utilisation de la violence est la plus efficace et la plus rentable lorsque les moyens sont soumis à des critères uniquement instrumentaux-rationnels, et ainsi dissociés de l'évaluation morale des fins ». Rien ne semble plus rationnel qu'une recommandation faite par un ordinateur, aussi imparfaite que puisse être cette décision dans son contexte.

Dans une organisation où les décisions sont médiées par un logiciel, la responsabilité des résultats est complètement diffuse. Ceux d'entre nous qui construisent les systèmes de prise de décision sont considérés comme des travailleurs spécialisés : notre code fonctionne-t-il ? Est-ce efficace et rapide ? Avons-nous ajouté les nouvelles fonctionnalités demandées ?

La gestion d'une telle organisation est loin d'être « pointue », où les avantages sont refusés, où les immigrants sont détenus, où les candidats sont accusés d'être des tricheurs parce qu'ils ne peuvent pas regarder un écran sans cligner pendant des heures. Les membres du personnel de base sont censés travailler au sein du système, et leur plan d'action le plus simple consiste à suivre les recommandations du logiciel avec lequel ils travaillent.

Comme le conclut Bauman : «le résultat est la non-pertinence des normes morales pour le succès technique de la bureaucratie [soulignement de Bauman].' Une bureaucratie – comme toutes les grandes organisations modernes, des organisations qui administrent la protection sociale à l'armée – ne se soucie que de l'efficacité et du succès technique. La prise de décision informatisée tend à réduire encore plus l'importance du jugement humain. "La moralité se résume au commandement d'être un expert et un travailleur bon, efficace et diligent", selon Bauman.

La déshumanisation est l'antithèse de la dignité humaine et du respect des droits de l'homme. La seule fin logique à la montée de la déshumanisation numérique est d'automatiser la décision de mettre fin à des vies humaines - de construire et d'utiliser des armes autonomes.

Alors que les systèmes de prise de décision informatisés deviennent de plus en plus répandus dans nos systèmes d'éducation, de travail, de protection sociale et de justice, le respect de la dignité humaine et des droits de l'homme doit être une priorité. Les ingénieurs logiciels ne sont pas jugés sur notre contribution au respect des droits de l'homme dans nos évaluations de performance de fin d'année. Néanmoins, nous avons l'obligation de comprendre et d'atténuer les impacts négatifs des systèmes que nous construisons - et de nous abstenir de construire des systèmes qui nuisent et déshumanisent.

En 2019, une grande partie de l'industrie du logiciel a déclaré 'Pas de technologie pour ICE.' C'est un excellent message et il vaut la peine de le répéter, mais nous devons aller plus loin : « Pas de technologie déshumanisante ».

Photo de Maxim Hopman

Pour en savoir plus sur les robots tueurs et ce you pouvez faire, visitez: www.stopkillerrobots.org. Si cet article résonne avec vous en tant que technologue, consultez les ressources de la campagne pour arrêter les robots tueurs pour les travailleurs de la technologie : www.stopkillerrobots.org/tech.

- Zygmunt Bauman, Modernité et Holocauste (Polity Press, 1989), 115.

- Zygmunt Bauman, Modernité et Holocauste, 114.

- Zygmunt Bauman, Modernité et Holocauste, 117.

- Zygmunt Bauman, Modernité et Holocauste, 115.

Article original sur Medium.com.